Google Cloud, D-ID, Cohere estão usando novas plataformas para uma ampla gama de serviços generativos de IA, incluindo chatbots, conteúdo de texto para imagem, IA de vídeo e muito mais

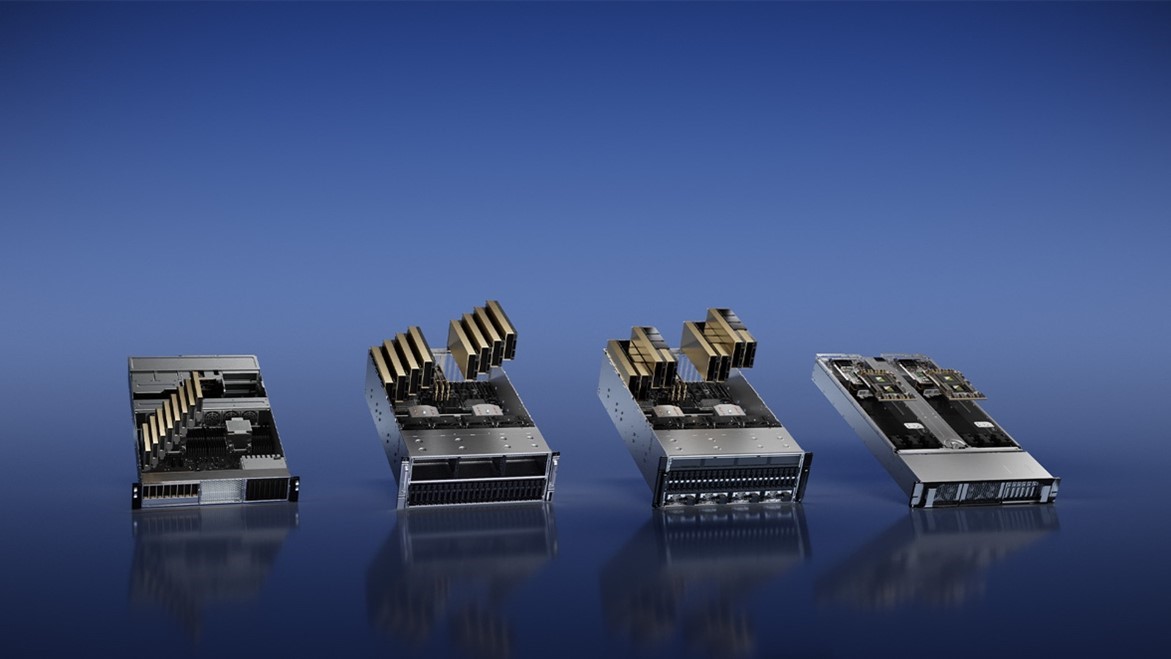

SANTA CLARA, Califórnia - GTC - 21 de março de 2023 - A NVIDIA lança quatro plataformas de inferência otimizadas para um conjunto diversificado de aplicações rápidas e emergentes de IAs generativas que ajudarão os desenvolvedores a construírem rapidamente aplicações especialmente impulsionadas por IA, que podem fornecer novos serviços e insights.

As plataformas combinam um stack completo de software de inferência da NVIDIA com os mais recentes processadores NVIDIA Ada, Hopper e Grace Hopper - incluindo a GPU NVIDIA L4 Tensor Core e a GPU NVIDIA H100 NVL, ambas também lançadas nesta semana. Cada plataforma é otimizada para cargas de trabalho sob demanda, incluindo IA de vídeo, geração de imagens, implementação de modelos em linguagem grande e recomendação de inferência.

"A ascensão da IA generativa está exigindo plataformas de computação de inferência mais poderosas", diz Jensen Huang, fundador e CEO da NVIDIA. "O número de aplicações para IA generativa é infinito, limitado apenas pela imaginação humana". Oferecer aos desenvolvedores a mais poderosa e flexível plataforma de computação de inferência acelerará a criação de novos serviços que melhorarão nossas vidas de formas ainda não imagináveis".

Acelerando um conjunto diversificado de cargas de trabalho de inferência de IA

Cada uma das plataformas contém uma GPU NVIDIA otimizada para cargas de trabalho específicas de inferência de IA generativa, bem como softwares especializados:

- NVIDIA L4 para IA de vídeo pode oferecer 120x mais performance de vídeo impulsionado por IA do que as CPUs, combinado com 99% melhor eficiência energética. Servindo como uma GPU universal para praticamente qualquer carga de trabalho, oferece recursos aprimorados de decodificação e transcodificação de vídeo, streaming de vídeo, realidade aumentada, vídeo de IA generativa e muito mais.

- NVIDIA L40 para geração de imagens é otimizada para gráficos e geração de imagens 2D, vídeo e 3D para IA. A plataforma L40 serve como o motor de NVIDIA Omniverse™, uma plataforma para construir e operar aplicações de metaverso no data center, fornecendo 7x a performance de inferência para difusão estável e 12x a performance do Omniverse em relação à geração anterior.

- NVIDIA H100 NVL para implantação de modelo de linguagem grande é ideal para implementar LLMs massivos, como o ChatGPT em escala. A nova NVL H100 NVL com 94GB de memória com aceleração do transformer engine proporciona uma performance de inferência até 12x mais rápida em GPT-3 em comparação com a geração anterior A100 em escala de data center.]

- NVIDIA Grace Hopper para modelos de recomendação é ideal para modelos de recomendação gráfica, bancos de dados vetoriais e redes neurais gráficas. Com a conexão NVLink-C2C de 900 GB/s entre CPU e GPU, o Grace Hopper pode fornecer transferências 7x mais rápidas e consultas de dados em comparação com a PCIe Gen 5.

As plataformas apresentam um layer de conjunto de softwares NVIDIA AI Enterprise, que inclui o NVIDIA TensorRT™, um kit de desenvolvimento de software para a inferência de deep learning de alto desempenho, e o NVIDIA Triton Inference Server™, um software de código aberto para a inferência que ajuda a padronizar a implementação do modelo.

"Grandes Modelos de Linguagem (LLMs) e chatbots oferecem muitos benefícios para empresas e organizações como, por exemplo, experiências personalizadas que podem economizar tempo e dinheiro para as companhias. Essa novidade contribuirá para diversos setores", destaca Marcio Aguiar, diretor da divisão Enterprise da NVIDIA para América Latina.

Adoção antecipada e suporte

O Google Cloud é um parceiro-chave das nuvens e um dos primeiros clientes das plataformas de inferência da NVIDIA. Ele está integrando a plataforma L4 em sua plataforma de machine learning, Vertex AI, e é o primeiro provedor de serviços de nuvem a oferecer instâncias L4, com prévia privada de suas máquinas virtuais G2 lançadas.

NVIDIA e Google anunciaram separadamente duas das primeiras organizações a ter acesso antecipado ao L4 no Google Cloud - Descript, que usa IA generativa para ajudar os criadores a produzir vídeos e podcasts, e WOMBO, que oferece, impulsionado por IA, texto para a aplicação de arte digital chamado Dream.

Kuaishou é outra empresa que fornece um aplicativo de vídeo curtos que aproveita as GPUs para decodificar a entrada de vídeo streaming ao vivo, capturar quadros-chave e otimizar áudio e vídeo. Ele então usa um modelo de grande escala baseado em transformer para entender o conteúdo multimodal e melhorar as taxas de “click-through” para centenas de milhões de usuários em todo o mundo.

"O sistema de recomendação Kuaishou serve uma comunidade com mais de 360 milhões de usuários diários que contribuem diariamente com 30 milhões de vídeos UGC", diz Yue YU, vice-presidente sênior da Kuaishou. "Em comparação com as CPUs sob o mesmo custo total de propriedade, as GPUs da NVIDIA têm aumentado o rendimento de ponta a ponta do sistema em 11x, e reduzido a latência em 20%".

D-ID, uma plataforma de tecnologia de IA generativa líder, eleva o conteúdo de vídeo para profissionais usando GPUs NVIDIA L40 para gerar humanos digitais fotorrealistas a partir de texto - dando um rosto a qualquer conteúdo enquanto reduz o custo e o incômodo da produção de vídeo em escala.

"O desempenho da L40 foi simplesmente incrível. Com ela, conseguimos dobrar nossa velocidade de inferência", afirma Or Gorodissky, vice-presidente de pesquisa e desenvolvimento da D-ID. "A D-ID está entusiasmada em usar este novo hardware como parte de nossa oferta que permite a transmissão em tempo real da IA humana com desempenho e resolução sem precedentes, reduzindo simultaneamente nossos custos computacionais".

Seyhan Lee, um dos principais estúdios de produção de IA, usa a IA generativa para desenvolver experiências imersivas e conteúdos criativos para os filmes, broadcast e indústrias de entretenimento.

"A GPU L40 proporciona um incrível impulso na performance para nossas aplicações de IA generativas", conta Pinar Demirdag, co-fundador de Seyhan Lee. "Com a capacidade de inferência e tamanho da memória da L40, podemos implementar modelos de última geração e fornecer serviços inovadores a nossos clientes com incrível velocidade e precisão".

A Cohere, pioneira líder em IA de linguagem, administra uma plataforma que capacita os desenvolvedores a construir modelos de linguagem natural, mantendo os dados privados e seguros.

"A nova plataforma de inferência H100 de alto desempenho da NVIDIA pode nos permitir fornecer serviços melhores e mais eficientes a nossos clientes com nossos modelos generativos de última geração, potencializando uma variedade de aplicações de PNL, tais como IA conversacional, busca empresarial multilíngue e extração de informações", diz Aidan Gomez, CEO da Cohere.

Disponibilidade

Além do Grace Hopper Superchip e da GPU H100 NVL, que são esperados para o segundo semestre do ano, a plataforma de inferência da NVIDIA para IA generativa está disponível imediatamente através da rede mundial de fabricantes de computadores e parceiros provedores de serviços em nuvem.

A GPU NVIDIA L4 está disponível em preview privada na plataforma Google Cloud e também disponível a partir de uma rede global de mais de 30 fabricantes de computadores, incluindo Advantech, ASUS, Atos, Cisco, Dell Technologies, Fujitsu, GIGABYTE, Hewlett Packard Enterprise, Lenovo, QCT e Supermicro.

A GPU NVIDIA L40 está atualmente disponível a partir dos principais integradores, incluindo ASUS, Dell Technologies, GIGABYTE, Lenovo e Supermicro, com o número de plataformas parceiras definidas para se expandir ao longo do ano.

A NVIDIA AI Enterprise está agora disponível nos principais marketplaces de nuvem e de dezenas de fornecedores e parceiros de sistemas. Com o NVIDIA AI Enterprise, os clientes recebem Suporte Empresarial NVIDIA, revisões regulares de segurança e estabilidade da API para o NVIDIA Triton Inference Server™, TensorRT™ e mais de 50 modelos e estruturas pré-treinadas.

Laboratórios práticos para experimentar a plataforma de inferência NVIDIA para IA generativa estão disponíveis imediatamente, sem custo, no NVIDIA LaunchPad. Os laboratórios de amostra incluem treinamento e implementação de um chatbot de suporte, implementação de uma carga de trabalho ponta-a-ponta de IA, ajuste e implementação de um modelo de linguagem na H100 e implementação de um modelo de detecção de fraude com o NVIDIA Triton.

Sobre a NVIDIA

Desde sua fundação em 1993, a NVIDIA (NASDAQ: NVDA) tem sido pioneira em computação acelerada. A invenção da GPU pela empresa em 1999 estimulou o crescimento do mercado de games para PC, redefiniu a computação gráfica, iniciou a era da IA moderna e tem ajudado na criação do metaverso. A NVIDIA agora é uma empresa de computação full-stack com soluções em escala de data center que estão revolucionando o setor. Mais informações em: https://blog.nvidia.com.br/.

Acesse também:

Site oficial da NVIDIA no Brasil: https://www.nvidia.com/pt-br/

Facebook: @NVIDIABrasil

Twitter: @NVIDIABrasil

YouTube: NVIDIA Latinoamérica

Informações para a imprensa:

Sing Comunicação de Resultados

21/03/2023